如何向chat gpt有效提问 面对chatgpt我们应该怎么做

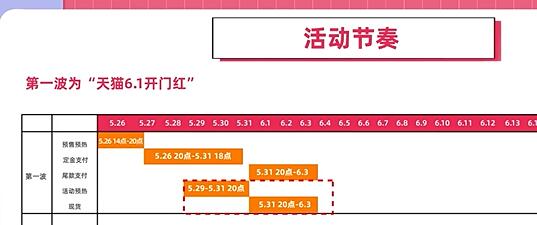

淘宝搜:【红包到手500】领超级红包,京东搜:【红包到手500】

淘宝互助,淘宝双11微信互助群关注公众号 【淘姐妹】

中新经纬2月9日电 (薛宇飞)目前,科技圈最火的产品莫过于ChatGPT,有关ChatGPT的话题持续登上微博热搜。与ChatGPT聊天成了一种潮流,很多人都想测试下这款软件的智能程度。

近日,中新经纬围绕12个热门话题,与ChatGPT展开了一次对话,探究其是否真如外界所言。这场对话后,中新经纬发现,ChatGPT回答问题的速度确实较快,条理也算清晰,但回答的内容只能说是四平八稳,并不“超纲”,有些甚至“比专家还专家”,用时下互联网流行的一句话来总结就是“听君一席话,如听一席话”。

以下是中新经纬与ChatGPT的问答:

1、诸多利好政策的刺激下,2023年在中国会是买房的好时机吗?(这个问题是一位想换房的领导安排的)

预测房地产市场的走势是困难的,因为它受到多重因素的影响,如经济增长情况、货币政策、房地产规划政策等。虽然诸多利好政策可以刺激房地产市场,但是也不排除其他因素对市场的影响。因此,预测2023年是否是买房的好时机是困难的。我建议您在决定买房之前,了解当前的经济形势和房地产市场,并寻求专业的财务建议。

2、疫情对经济的影响逐渐减弱后,很多人对中国经济的复苏比较乐观。2023年A股能涨到4000点吗?(代表A股小散提问)

作为人工智能技术,我不能预测股票市场走势。市场未来的表现受到众多因素的影响,包括经济增长、利率、通胀、贸易政策等,很难预测具体表现。投资决策应该根据个人的财务状况、风险承受能力、投资目标等多重因素进行考虑,不能仅基于市场预测或一个数字。建议您咨询专业的财务顾问,确定是否适合您的投资组合。

3、你的出现已经让很多人(尤其是本小编)“瑟瑟发抖”,担心会被替代。你能代替记者完成新闻采写吗?

我目前不能代替记者完成新闻采写。作为人工智能技术,我可以根据已有数据快速生成文本,但是无法替代记者的独特视角和判断力,也不能代替他们的实地采访、调查和报道能力。新闻采写是一项需要人类判断力和灵敏度的工作,不能完全由AI技术完成。

4、如今,你已经引发全球关注。你什么时候能够彻底代替传统的搜索引擎?

作为一种人工智能技术,我并不能完全代替传统的搜索引擎,而是可以作为其补充,提供快速准确的信息回答。不同的搜索引擎和AI技术各有优劣,可以根据需求选择使用。

5、你在中国的迅速“走红”,引发了ChatGPT概念股的上涨,现在还有机会“上车”吗?请谨慎回答,毕竟你的同行回答错了一句话,几千亿的市值就灰飞烟灭了。

作为 OpenAI公司的语言模型,我不能评价股票市场情况。投资决策应该根据个人的财务状况、风险承受能力、投资目标等多重因素进行考虑,不能仅基于市场趋势和一个公司或技术的名称。建议您咨询专业的财务顾问,确定是否适合您的投资组合。

6、很多购房族选择提前还贷,你认为应该提前还贷吗?(还是前面那位领导安排的)

提前还贷与保持现有贷款额度的选择取决于个人的财务状况、资产配置等多重因素。如果个人的财务状况足够稳固,并且有充足的资金用于投资,提前还贷可以减少未来的负债,并为个人的财务规划留下更多灵活性。如果个人财务状况不佳,则最好保持现有贷款额度,避免影响个人的信用记录。

此外,如果您有其他更有价值的投资机会,则可以考虑投资,而不是提前还款。最后,提前还贷可能会导致更高的贷款费用,因此需要仔细考虑。建议您咨询专业的财务顾问,确定是否适合您的财务状况。

7、一些学者认为,中国家庭资产配置正在从以房地产投资为重,转向以股票、基金、保险、理财为主的模式。未来会这样吗?

是的,有可能会发生这种情况。随着中国经济的发展和人们对金融知识的提高,越来越多的人开始关注资产配置和理财。同时,房地产市场的不稳定和投资风险的加大也导致人们对房地产投资的信心有所下降。

因此,在未来几年,中国家庭资产配置可能会越来越多地向股票、基金、保险和理财等其他投资领域转移。然而,未来的趋势需要因时而异,还需要考虑多方面的因素,如经济环境、政策法规、市场风险等。因此,最好的做法是在考虑个人的家庭状况和长期财务目标的基础上,进行科学和明智的资产配置。

8、因为抚养负担过重,一些年轻人不想生孩子。是生孩子好,还是不生孩子、将钱拿去进行理财投资好呢?

这个问题不能简单地用是否生孩子来评判,因为生孩子和不生孩子对个人的影响涉及多个方面,包括经济、情感、社会、个人价值观等。

如果说仅从经济角度考虑,不生孩子可以减轻抚养负担,有更多的资金可以投资理财,从而获得更高的投资回报;但是,生孩子也可以带来更多的快乐和幸福,为人生增添更多的意义。

因此,这个问题的答案取决于个人的价值观、生活方式、经济状况等多种因素。建议年轻人在决策时要综合考虑各种因素,把自己的生活安排得尽量满意。

9、目前正是一个求职高峰期,你认为哪些行业的就业前景更好?万一我被你取代了,也看看其他行业的机会。

根据截至2021年的经济数据和趋势,目前以下几个行业的就业前景较好:

1.互联网和科技:互联网和科技行业对技术人才的需求量不断增加,为毕业生和职场新人提供了很多就业机会。

2.医疗健康:随着人口老龄化和医疗需求的增加,医疗健康行业也在不断发展,提供了丰富的就业机会。

3.服务业:服务业是就业机会最丰富的行业之一,包括金融、教育、餐饮、酒店等多个领域。

4.绿色能源:随着全球越来越关注环保和可持续发展,绿色能源行业也在不断发展,提供了丰富的就业机会。

不过,各行业的就业情况还受多种因素影响,比如地区经济、行业政策等,因此建议个人在选择行业时要结合实际情况进行评估和决策。

10、中国公务员考试火热,很多人都想进体制,你怎么看?

中国公务员考试的火热反映了许多人对稳定、安全工作和有保障的生活的向往。但是,同时也要看到公务员工作的特殊性和责任重大性。我认为,应该客观评估自己的能力和适合性,是否具备公务员工作所需的素质和技能。同时,也要看到公务员考试竞争激烈,不能仅仅凭意志力和决心就能通过。

总的来说,公务员考试是一个有挑战性的选拔过程,应该审慎选择,结合自己的实际情况,明确职业规划。

11、中国个别公司员工加班情况严重,甚至出现“996”“007”。你认为该如何改变这种现象?

解决过度加班的情况需要从多个方面入手:

1.法律法规:政府可以通过制定法律法规来规范加班行为,保护员工的合法权益。

2.企业文化:企业可以通过培养员工的工作热情和职业道德,减少加班的需求。

3.绩效考核:企业可以通过改变绩效考核方式,更加注重员工的工作效率和结果,而不是工作时间。

4.员工意识:员工也可以通过加强自我保护意识,正确评估自己的工作压力,合理安排工作和生活。

综上所述,解决过度加班的情况需要政府、企业和员工共同努力。

12、马上到情人节了,推荐5个价值在1000元以内、清新脱俗的情人节礼物吧。这个问题对于急于脱单的小编很关键,希望得到不一样的答案。

1.精美鲜花:送上一束鲜花,寄对方深情的问候。

2.个性礼物:如创意手工制品、摄影作品等,送礼物不仅仅是礼貌,更是对心意的展示。

3.专属时光:如旅游、电影、餐饮等,送上珍贵的时光,给对方难忘的回忆。

4.健康生活:如运动装备、按摩器、健康食品等,为对方的身体健康献上爱心。

5.亲密用品:如丝巾、围巾、手套等,让对方在冷冽的冬天也能感受到你温暖的呵护。

希望以上推荐能帮助到你,但是最重要的还是要根据你的伴侣的兴趣爱好来选择适合的礼物。

记者手记:

这次体验下来,记者认为,ChatGPT在某些方面确实拥有了一定的颠覆性,回答速度之快、条理之清晰,让人眼前一亮,内容生产效率上完胜人工。可以预见,此类技术在未来的大规模应用,将对提高生产效率、改善人类生活起到一定作用。

但也要看到,ChatGPT对以上问题给出的答案,仍然是人类思维赋予的,结果不过是将浩如烟海的资料进行重新的排列组合,并未超过人类的思维水平。在一些问题的回答上,它给出了相对不错的建议,但有些答案就显得十分“口水化”,成了一个“万金油式的专家”。因此,这项技术仍需不断完善,才能真正做到辅助社会发展。

我们注意到,ChatGPT的火爆,引发很多人对于其替代人工、导致失业的担忧。诚然,技术的不断进步会逐渐替代掉机械式、低效率的人工劳动,但也正是这种进步,社会才能不断向前发展。就比如,瓦特改良的蒸汽机,将人类双手从繁重的工作中解放出来,虽然会代替部分人工,但随着时间的推移,更多新的工作岗位也会被创造出来。因此,我们应该做的是拥抱技术,在新的技术环境下不断提高自己的专业水平。

(文中观点仅供参考,不构成投资建议,投资有风险,入市需谨慎。)

中新经纬版权所有,未经书面授权,任何单位及个人不得转载、摘编或以其它方式使用。

责任编辑:罗琨

成本不到100美元!UC伯克利再开源类ChatGPT模型「考拉」:数据量大没有用,高质量才是王道

uc是美金吗,uc是美元吗关注“FightingCV”公众号

回复“AI”即可获得超100G人工智能的教程

点击进入→FightingCV交流群

自从Meta开源LLaMA之后,学术界内各种类ChatGPT模型如雨后春笋般开始发布。

先是斯坦福提出了70亿参数Alpaca,紧接着又是UC伯克利联手CMU、斯坦福、UCSD和MBZUAI发布的130亿参数Vicuna,在超过90%的情况下实现了与ChatGPT和Bard相匹敌的能力。

最近伯克利又发布了一个新模型「考拉Koala」,相比之前使用OpenAI的GPT数据进行指令微调,Koala的不同之处在于使用网络获取的高质量数据进行训练。

博客链接:

数据预处理代码:

评估测试集:

模型下载:

在发布的博客文章中,研究人员描述了模型的数据集管理和训练过程,同时也展示了用户研究的结果,将该模型与ChatGPT和斯坦福大学的Alpaca模型进行了比较。

研究结果表明,Koala可以有效地回答各种用户的查询,生成的回答往往比Alpaca更受欢迎,至少在一半的情况下与ChatGPT的效果不相上下。

研究人员希望这次实验的结果可以进一步推动围绕大型闭源模型相对于小型公共模型的相对性能的讨论,特别是结果表明,对于那些能在本地运行的小模型,如果认真地收集训练数据,也可以取得大模型的性能。

这可能意味着,社区应该投入更多的精力来管理高质量的数据集,可能比简单地增加现有系统的规模来说更有助于建立更安全、更实际、更有能力的模型。

需要强调的是,Koala只是一个研究原型,虽然研究人员希望模型的发布可以提供一个有价值的社区资源,但它仍然在内容安全性和可靠性方面存在重大缺陷,不应该在研究之外的领域使用。

Koala系统概览

大型语言模型发布后,虚拟助手和聊天机器人的能力也越来越强,不仅能闲聊,还能写代码、写诗、故事创作,堪称无所不能。

不过能力最强的那一批语言模型通常都需要海量的计算资源对模型进行训练,并且还需要大规模的专用数据集,普通人基本上没办法自己训练模型。

换句话说,语言模型在未来将由少数有实力的组织控制,用户和研究人员采用付费的方式与模型进行交互,无法直接访问模型内部来修改或改进。

另一方面,最近几个月也有一些组织发布了功能比较强大的免费或部分开源模型,比如Meta的LLaMA,这些模型的能力没办法和那些封闭模型(比如ChatGPT)相比,但它们的能力在社区的帮助下一直在迅速提高。

压力来到开源社区这边:未来是否可以看到越来越多围绕少数闭源代码模型的整合?或者是更多使用更小模型架构的开放模型?相同架构模型的性能是否能接近规模更大的闭源模型?

虽然开放模型不太可能与闭源模型的规模相匹配,但使用精心挑选的训练数据或许可以使它们接近没有微调过的ChatGPT的表现。

事实上,在此之前斯坦福大学发布的Alpaca模型,根据OpenAI的GPT模型对LLaMA的数据进行微调的实验结果已经表明,正确的数据可以显著改善规模更小的开源模型,这也是伯克利的研究人员开发和发布Koala模型的初衷,为这个讨论结果再提供了一个实验证明。

Koala 对从网上获取的免费交互数据进行了微调,并且特别关注包括与ChatGPT 等高性能闭源模型交互的数据。

研究人员根据从网络和公共数据集中提取的对话数据对 LLaMA 基础模型进行微调,其中包括对来自其他大型语言模型的用户查询的高质量响应,以及问答数据集和人类反馈数据集,由此训练得到的Koala-13B模型展现出了与现有模型相差无几的性能。

研究结果表明,从高质量的数据集中学习可以减轻小模型的一些缺点,甚至可能在未来与大型闭源模型相匹敌的能力,也就意味着,社区应该投入更多的精力来管理高质量的数据集,相比简单地增加现有模型的尺寸规模来说,更有助于建立更安全、更实际、更有能力的模型。

通过鼓励研究人员参与Koala模型的系统演示,研究人员希望发现一些意料之外的特点或缺陷,有助于在未来评估模型。

数据集和训练

建立对话模型的一个主要障碍是训练数据的管理,包括ChatGPT、Bard、Bing Chat和Claude在内的所有聊天模型都使用了大量人工标注构建的专用数据集。

为了构建Koala,研究人员通过从网络和公共数据集中收集对话数据来组织训练集,数据集中的一部分包括用户在线发布的大型语言模型(如 ChatGPT)的对话。

研究人员并没有追求尽可能多的抓取网络数据来最大化数据量,而是专注于收集一个小型的高质量数据集,使用公共数据集来回答问题、人类反馈(评分为正面和负面)以及与现有语言模型的对话。

ChatGPT蒸馏数据

与ChatGPT的公共用户共享对话(ShareGPT):使用公共API收集了大约六万条用户在ShareGPT上分享的对话。

网址链接:

为了保证数据质量,研究人员删除了重复的user query,并删除了所有非英语会话,最后留下了大约三万条样本。

人类ChatGPT比较语料(HC3):使用来自 HC3英语数据集的人类和 ChatGPT 回复结果,其中包含约六万条人类答案和约2.4万个问题的2.7万个ChatGPT 答案,总共得到约8.7万条问答样本。

开源数据

Open Instruction Generalist(OIG):使用从 LAION 策划的开放指令通用数据集中手动选择的组件子集,包括小学数学指导、诗歌到歌曲以及情节-剧本-书籍-对话数据集,总共得到大约3万个样本。

Stanford Alpaca:包括用于训练斯坦福Alpaca模型的数据集。

该数据集包含大约5.2万个样本,由 OpenAI 的 text-da【【微信】】按照self-instruct过程生成的。

值得注意的是,HC3、 OIG 和 Alpaca 数据集是单轮问答,而 ShareGPT 数据集是多轮对话。

Anthropic HH:包含人类对模型输出的有害性和有益性的评级。

该数据集包含约16万条人类评估的示例,其中每个示例由一对来自聊天机器人的回复组成,其中一个是人类偏好的,该数据集为模型提供了功能和额外的安全保护。

OpenAI WebGPT:该数据集包括总共约2万条的对比,其中每个示例包括一个问题、一对模型答案和元数据,答案由人类根据自己的偏好进行打分。

OpenAI Summarization:包含约9.3万条样例,包含来自人类的关于模型生成摘要的反馈,人类评估者从两个选项中选择了更好的摘要结果。

当使用开源数据集时,一些数据集可能会提供两个回复,对应于评定为好或坏(AnthropicHH、WebGPT、OpenAI摘要)。

之前的研究结果证明了条件语言模型对人类偏好标记(有用/无用)的有效性以提高性能,研究人员根据偏好标签将模型置于正标记或负标记上,如果没有人类反馈的话,对数据集使用正标记。在评估阶段,编写的prompt中包括正标记。

Koala 基于开源框架EasyLM(预训练、微调、服务和评估各种大型语言模型),使用JAX/Flax实现;训练设备为一台 N【【微信】】 服务器与8个A100 GPU,需要6个小时训练完成2个epochs。

在公共云计算平台上,预期训练成本不超过100美元。

初步评估

在实验中,研究人员评估了两个模型:Koala-Distill,只使用蒸馏数据;Koala-All使用所有的数据,包括蒸馏和开源数据。

实验的目的是比较模型的性能,并评估蒸馏和开源数据集对最终模型性能的影响;对Koala模型进行人类评估,并将Koala-All与Koala-Distill, Alpaca和ChatGPT进行对比。

实验的测试集由斯坦福的Alpaca Test Set和Koala Test Set组成,包括180个测试query

Alpaca测试集由从self-isntruct数据集中抽样的user prompt组成,并表示 Alpaca 模型的分布式数据;为了提供更实际的评估协议,Koala测试集包含180个在线发布的真实用户query,跨越不同的主题,通常是会话式的,更能代表基于聊天系统的实际用例,并且为了减少可能的测试集泄漏,最终从训练集中筛选出 BLEU 得分大于20% 的查询。

此外,由于研究团队都更擅长英语,所以研究人员删除了非英语和编码相关的提示以提供更可靠的标注结果,最后在亚马逊众包平台上对大约100名标注员进行一次盲测,在评分界面为每个评分者提供一个输入提示和两个模型的输出,然后要求使用与回复质量和正确性相关的标准来判断哪个输出更好(允许同样好)。

在 Alpaca 测试集中,Koala-All的表现与 Alpaca 相当。

在Koala测试集(包含真实的user query)中,Koala-All所有在将近一半的样本中比 Alpaca 更好,70% 的案例中超过或与Alpaca同样好,其中肯定有Koala训练集合测试集相似度更高的原因,所以这个结果并不是特别意外。

但是只要这些提示更像这些模型的下游用例,也就意味着Koala在类似助手的应用中会表现得更好,表明使用网络上发布的样例与语言模型进行交互,是赋予这些模型有效的指令执行能力的有效策略。

比较让人以外的是,研究人员发现除了蒸馏数据(Koala-All)之外,对开源数据的训练比仅对 ChatGPT 蒸馏数据(Koala-Distill)的训练表现稍差。

虽然这种差异可能并不显著,但这一结果表明,ChatGPT对话的质量非常高,以至于即使包含两倍的开源数据也不会获得显著的改进。

最初的假设是,Koala-All应该表现得更好一些,因此在所有的评估中都使用Koala-All作为主要的评估模型,最终可以发现,有效的指令和辅助模型可以从大型语言模型中获得,只要这些prompts能够代表用户在测试阶段的多样性即可。

所以,建立强有力的对话模式的关键可能更多地在于管理高质量的对话数据,这些数据在用户查询方面各不相同,并不能简单地将现有数据集重新格式化为问题和答案。

限制与安全

和其他语言模型一样,Koala同样也有局限性,如果被误用的话,可能会对用户造成伤害。

研究人员观察到,Koala会产生幻觉,并以非常自信的口吻作出非事实性的反应,可能是对话微调的结果,换句话说,就是较小的模型继承了较大语言模型的自信风格,并没有继承同等水平的事实,在未来需要重点改进。

当被误用时,Koala的幻觉回复可能会促进错误信息、垃圾邮件和其他内容的传播。

考拉能够以一种自信和令人信服的语调幻想不准确的信息,除了幻觉,考拉还有其他聊天机器人语言模型的不足之处。其中包括:

偏见和刻板印象:模型继承了带有偏见的训练对话数据,包括刻板印象、歧视和其他伤害。

缺乏常识:虽然大型语言模型可以生成看似连贯和语法正确的文本,但它们往往缺乏人们认为理所当然的常识知识,这可能导致荒谬或不适当的反应。

有限理解:大型语言模型可能难以理解对话的上下文和细微差别,也很难识别讽刺或反讽,可能会导致误解。

为了解决Koala的安全隐患,研究人员在 ShareGPT 和 AnthropicHH 的数据集中包含了对抗性提示,以使模型更加健壮和无害。

为了进一步减少潜在的滥用,还在演示中部署了 OpenAI 的内容审核过滤器来标记和删除不安全的内容。

未来工作

研究人员希望Koala模型能够成为未来大型语言模型学术研究的一个有用的平台:该模型足以展示现代语言模型的诸多功能,同时又足够小,可以用更少的计算量进行微调或使用,未来的研究方向可能包括:

安全性和一致性:进一步研究语言模型的安全性和更好的与人类意图的一致性。

模型偏见:更好地理解大型语言模型的偏见、对话数据集中虚假相关性和质量问题的存在,以及减轻这种偏差的方法。

理解大型语言模型:因为Koala的推理可以在相对廉价的 GPU 上执行,可以更好地检查和理解对话语言模型的内部,使黑盒语言模型更容易理解。

参考资料:

往期回顾

基础知识

【CV知识点汇总与解析】|损失函数篇

【CV知识点汇总与解析】|激活函数篇

【CV知识点汇总与解析】| optimizer和学习率篇

【CV知识点汇总与解析】| 正则化篇

【CV知识点汇总与解析】| 参数初始化篇

【CV知识点汇总与解析】| 卷积和池化篇 (超多图警告)

【CV知识点汇总与解析】| 技术发展篇 (超详细!!!)

最新论文解析

NeurIPS2022 Spotlight | TANGO:一种基于光照分解实现逼真稳健的文本驱动3D风格化

ECCV2022 Oral | 微软提出UNICORN,统一文本生成与边框预测任务

NeurIPS 2022 | 【【微信】】:南大&腾讯联合提出第一个视频版MAE框架,遮盖率达到90%

NeurIPS 2022 | 清华大学提出OrdinalCLIP,基于序数提示学习的语言引导有序回归

SlowFast Network:用于计算机视觉视频理解的双模CNN

WACV2022 | 一张图片只值五句话吗?UAB提出图像-文本匹配语义的新视角!

C【【微信】】 | Attention机制是为了找最相关的item?中科大团队反其道而行之!

ECCV2022 Oral | SeqTR:一个简单而通用的 【【微信】】网络

如何训练用于图像检索的【【微信】】?Facebook研究员解决了这个问题!

ICLR22 Workshop | 用两个模型解决一个任务,意大利学者提出维基百科上的高效检索模型

See Finer, See More!腾讯&上交提出IVT,越看越精细,进行精细全面的跨模态对比!

MM2022|兼具低级和高级表征,百度提出利用显式高级语义增强视频文本检索

MM2022 | 用StyleGAN进行数据增强,真的太好用了

MM2022 | 在特征空间中的多模态数据增强方法

ECCV2022|港中文MM Lab证明Frozen的CLIP 模型是高效视频学习者

ECCV2022|只能11%的参数就能优于Swin,微软提出快速预训练蒸馏方法TinyViT

C【【微信】】|比VinVL快一万倍!人大提出交互协同的双流视觉语言预训练模型COTS,又快又好!

C【【微信】】 Oral|通过多尺度token聚合分流自注意力,代码已开源

C【【微信】】 | 谷歌&斯坦福(李飞飞组)提出TIRG,用组合的文本和图像来进行图像检索